Sinds vorige week heb ik een opensource ChatGPT op mijn Windows-computer geïnstalleerd en ik ben erg enthousiast over de resultaten. Deze software werkt volledig offline en wist alle gegevens automatisch na gebruik, waardoor het een super handige en privacyvriendelijke oplossing is.

Wat is het doel van de software?

Het doel van deze software is om een lokale, opensource versie van ChatGPT te bieden die niet afhankelijk is van externe servers of diensten. Hierdoor heb je volledige controle over je gegevens en kun je ze gebruiken zonder dat ze worden opgeslagen of gedeeld met derden.

Wat zijn de individuele componenten?

De software bestaat uit drie hoofdcomponenten:

- Ollama: een opensource-platform dat het LLaMA-model implementeert en je in staat stelt om ChatGPT lokaal te gebruiken.

- Docker: een containerisatieplatform dat het mogelijk maakt om Ollama en andere software te installeren en uit te voeren op je computer.

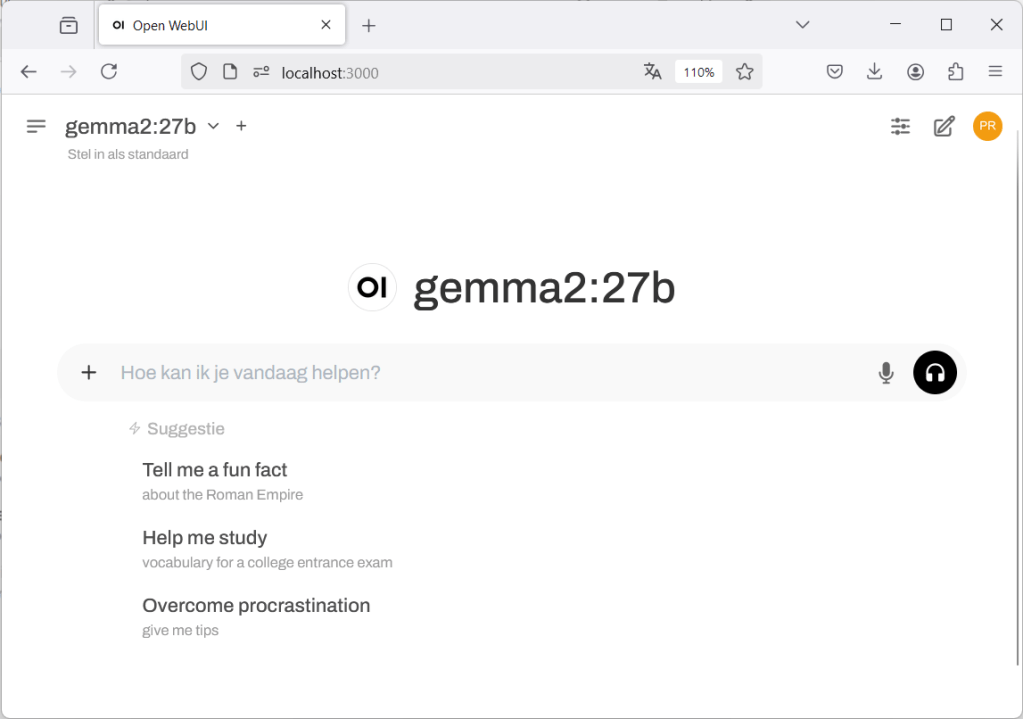

- Open WebUI: een webinterface die het mogelijk maakt om de software te gebruiken via een webbrowser.

Hoe kun je het zelf proberen?

Zo installeer je eenvoudig je eigen opensource ChatGPT op je Windows-computer:

- Installeer de benodigde software (Ollama, Docker en Open WebUI). Pak wat te drinken en volg de YouTube video.

- Ollama kan draaien op je processor (CPU) maar voor betere prestaties kies je voor een computer of laptop met een grafische kaart (GPU). Mijn advies is gewoon te starten, maar wil je meer informatie kijk dan in de GPU documentatie.

- Probeer verschillende LLM-modellen (Large Language Model) uit om te ervaren welke het beste werkt voor jouw specifieke taak. Zoek een passend model via de zoekfunctie op de Ollama-website.

Een aanbevolen LLM-model

Een LLM-model waar ik goede ervaring mee heb is Gemma2. Met Nederlandse tekst werkt het 27b-model goed, en het 9b-model goed genoeg (soms met enkele vertaalfoutjes). Het kleine 2b-model kan interessant zijn als je computer minder stevig is uitgerust maar daar heb ik zelf geen ervaring mee.

Privacy

In de Ollama FAQ lees je de vraag “Does Ollama send my prompts and answers back to ollama.com?” met antwoord “No. Ollama runs locally, and conversation data does not leave your machine.”. Omdat het opensource software is kan je dit zelf controleren.

Conclusie

Een opensource ChatGPT op je Windows-computer is een geweldige manier om meer controle te krijgen over je gegevens en om flexibel te kunnen werken met taalmodellen. Als je vragen hebt of hulp nodig hebt bij de installatie, laat het me weten!

Deze blog is geschreven met hulp van AI …

Op basis van mijn LinkedIn bericht en de informatie in mijn mijn commentaren is deze blogpost opgesteld. Via onderstaande prompt aan model llama3.1 kreeg ik deze blogpost terug. Paar kleine dingen aangepast en klaar is Kees 🙂

Schrijf een blogpost op basis van een LinkedIn bericht dat ik vandaag heb opgesteld. Leg eerst kort het doel uit van de software, en het doel van de individuele componenten. Verwerk onderstaande inhoud aangevuld met informatie die je bij het bericht vind passen. Gebruik een zakelijk informele maar actieve schrijfstijl.

Bericht op mijn eigen LinkedIn pagina:

- Sinds vorige week heb ik een opensource ChatGPT op mijn Windows-computer 🤖 Het werkt volledig offline en wist alles automatisch na gebruik. Super handig en privacyvriendelijk. 👌Wil je dit zelf ook proberen? In de comments vind je een uitgebreidere uitleg. Binnen 30 minuten heb je het zelf draaien en start het experimenteren. Veel plezier! 💡#privacy #opensource #lokaal #windows #ollama #docker #openwebui #chatgpt

De LinkedIn post heb ik uitgebreid met een aantal aanvullingen:_

- (1/7) Een korte YouTube-video over het installeren van benodigde software Ollama, Docker en Open WebUI op Windows. https://www.youtube.com/watch?v=OMsN4ZFpdxo

- (2/7) Het uitzoeken van het juiste LLM model voor een taak is een uitdaging. Kijk eens rond op https://ollama.com/search .

- (3/7) Ideaal is een computer of laptop met een NVIDIA grafische kaart. Past het model dat je gebruikt op je grafische kaart dan heb je de snelste reactie. Past het model niet helemaal op je grafische kaart dan wordt het geheugen em processor gebruikt, daardoor reageert het (veel) trager. Is het model te groot voor het geheugen zoek dan een kleiner model en probeer het opnieuw. In het begin is het even puzzelen.

- (4/7) Een LLM model waar ik goede ervaring mee heb is Gemma2. Met Nederlandse tekst werkt het 27b model goed, en het 9b model goed genoeg (soms wat vertaalfoutjes). Het kleine 2b model gebruik ik niet maar kan interessant zijn als je computer minder stevig is uitgerust.

- (5/7) Om te experimenteren heb ik een grotere grafische kaart gekocht. Gemma2:27b draait met enige moeite op mijn computer (55% CPU, 45% GPU). Het kleinere Gemma2:9b draait razendsnel (100% GPU) en dat werkt erg prettig.

- (6/7) Question “Does Ollama send my prompts and answers back to ollama.com?” Answeg “No. Ollama runs locally, and conversation data does not leave your machine.” https://github.com/ollama/ollama/blob/main/docs/faq.md#does-ollama-send-my-prompts-and-answers-back-to-ollamacom

- (7/7) Laat me weten als je vragen hebt, succes!